Как взломать вк. Взлом вконтакте.

Как взломать вк. Взлом вконтакте.

Сразу оговорюсь,статья написана для того,чтобы человек прочитав и узнав все методы взлома смог себя обезопасить.

Понастоящему стоящий аккаунт добыть НЕВОЗМОЖНО.

Программ для взлома ВК не существует!!Запомните.Под видом таких программ почти всегда идут трояны именно для того,чтобы украсть ваш аккаунт.

Как защититься от взлома узнаете в моей статье!!

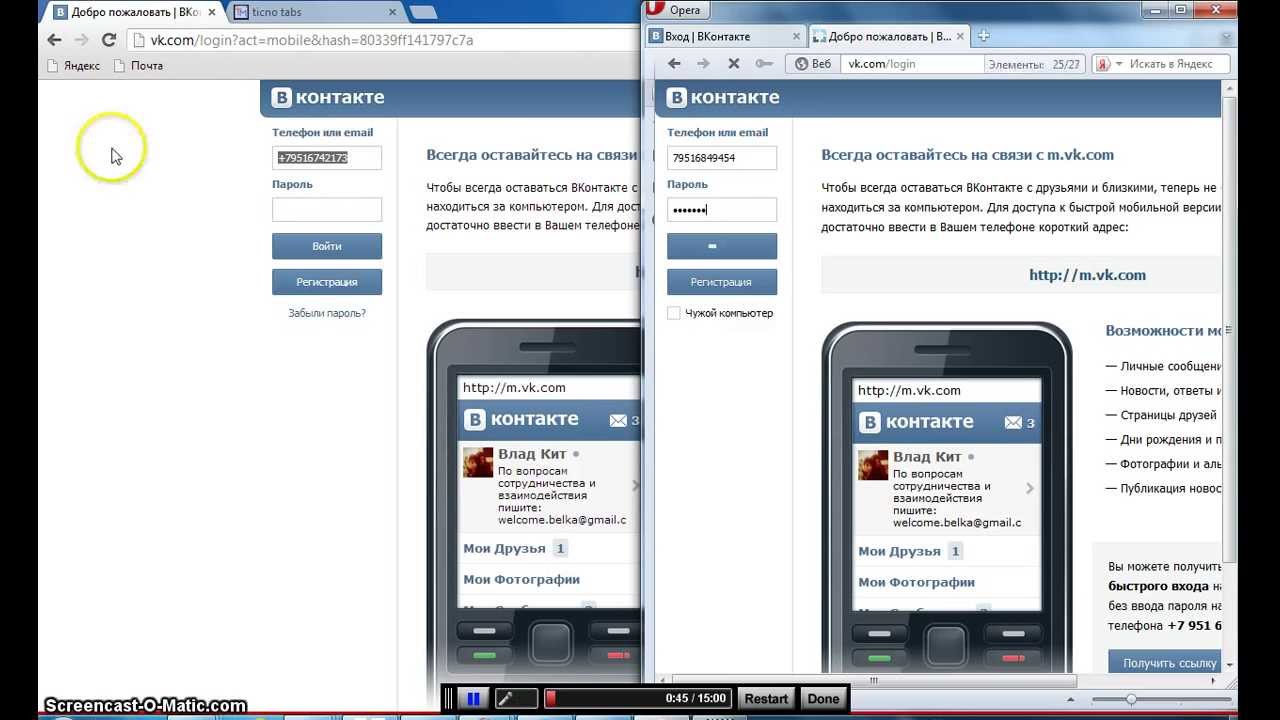

1. Один из самых популярных методов взлома страницы вконтакте — это фишинг.

Фишинг — маскировка мошеннического сайта под дизайн Вконтакте. При заходе на такой сайт Вам необходимо будет зайти под своим логином и паролем. Тем самым Вы показываете злоумышленникам свои данные.

Внешне Вы почти не отличите вредоносный сайт от настоящего Вконтакте. За исключением:

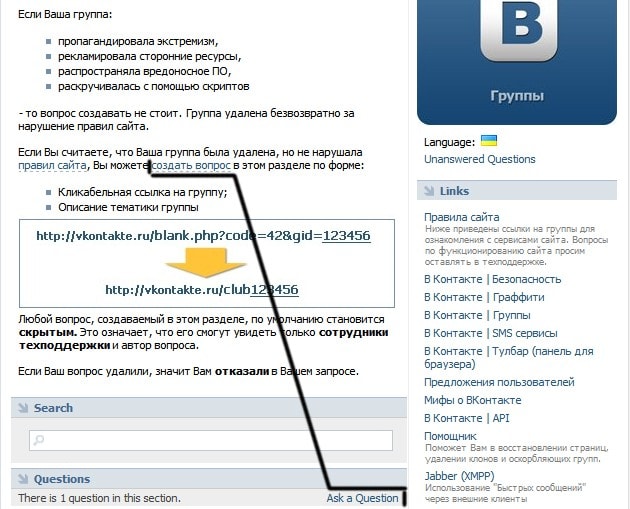

- Адрес сайта — всегда смотрите на адрес Вконтакте. Он должен быть http://vk.com другого не дано,еще мобильная версия http://m.

2. Малоэффективный метод взлома — Бруттфорс.

Брут — способ взлома путём подбора логина и пароля при помощи программного метода

- Устанавливайте сложный пароль — состоящий не только из цифр, но и латинских букв и тогда его будет нереально подобрать даже программно!!

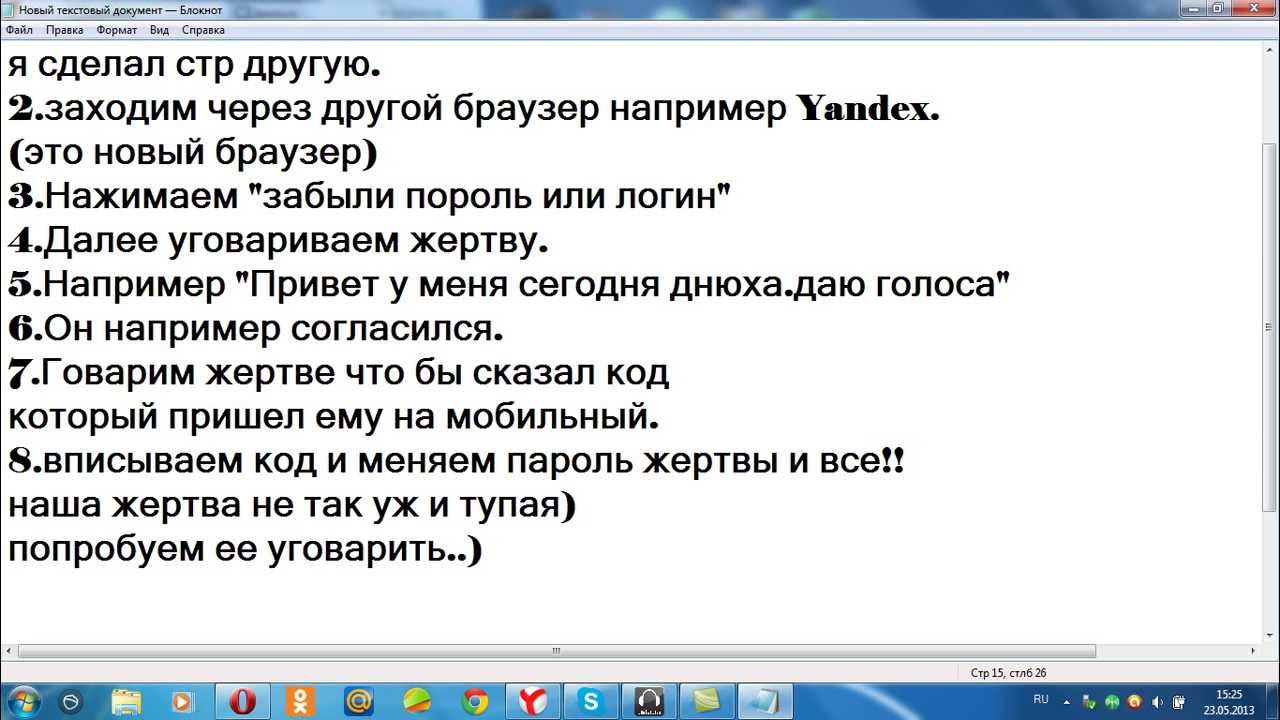

3. Самый действенный метод — это социальная инженерия — тоесть когда у вас под какими либо предлогами пытаются вытянуть в личной беседе логин и пароль,часто представляясь администрацией.

Нужно уяснить главное правило — не пишите и не сообщайте никому пароль,ни при каких обстоятельствах.

4. Вирусы-трояны

Этот тип вирусов пробирается на ваш компьютер из сомнительных сайтов, программ и архивов. После того, как вирус активируется, он ворует ваши пароли и отсылает их злоумышленнику.

Обычно такие вирусы содержатся в программах, позволяющих получить голоса или подарки «бесплатно».

Никогда не скачивайте незнакомые программы с неофициальных сайтов,если ваш уровень владения компьютером не позволяеть определять программы потенциально опасные.И конечно же антивирус.

5.

Использование файлов cookie

На компьютерах хранятся файлы cookie, которые отвечают за предоставление при запросах электронной почты и зашифрованного пароля + номера телефона. Пользователям удобно сохранять в таких файлах своих данные и не вводить при входе в социальную сеть свой пароль и логин. Этим и будем пользоваться, а получив файл cookie, узнаем на какой емаил зарегистрирована страница Вконтакте и даже получим зашифрованный пароль к ней. Расшифровать простой небольшой пароль элементарно!

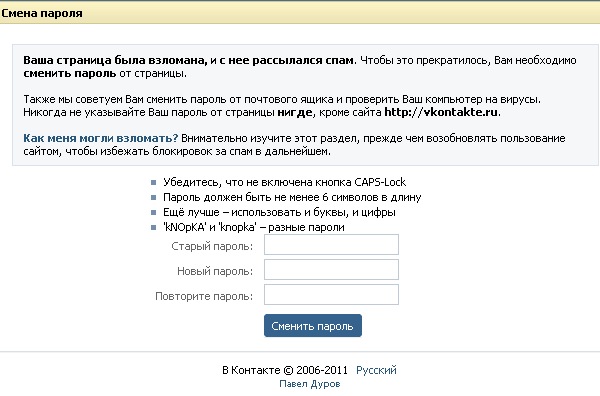

6. Не оставляйте страницу во вхожденном состоянии,когда сидит с чужого компьютера,например у друзей.

Следующее Предыдущее Главная страница

Подписаться на: Комментарии к сообщению (Atom)

Когнитивный хакинг: как искусственный интеллект нас обманывает и почему мы ему верим

Искусственный интеллект уже научился давать ответы на важные для человека вопросы, и иногда эти ответы даже можно с пользой применять. Однако проблема в том, что понять, как именно эти ответы появились, зачастую не могут даже разработчики этой системы, имеющие доступ к коду. При этом роботы умеют взламывать наше доверие и иногда «галлюцинируют», то есть говорят неправду. Forbes публикует отрывок из книги самого известного в мире эксперта по кибербезопасности Брюса Шнайера «Взломать все» о том, как это происходит и почему брови помогают искусственному интеллекту нас обманыватьСлово «хак» в известном нам сейчас значении появилось в 1950-х в Массачусетском технологическом институте и изначально означало просто некий изобретательный способ решать проблемы, и только со временем «хак» и «хакер» обрели оттенок противозаконной антиобщественной деятельности. В 1980-х «хакингом» стали называть почти исключительно взлом систем компьютерной безопасности с той или иной криминальной целью.

В 1980-х «хакингом» стали называть почти исключительно взлом систем компьютерной безопасности с той или иной криминальной целью.

Легендарный эксперт по кибербезопасности, криптограф, гарвардский профессор и автор бестселлеров Брюс Шнайер считает, что хакерские приемы окружают нас повсюду, и чтобы вовремя распознавать попытки «взломать» наш банковский счет, наш компьютер, наш мозг или наши гражданские права, нужно в свою очередь обладать хакерским мышлением. По его мнению, хаки бывают моральными и аморальными, причем эти понятия не тождественны «законные и незаконные». Не противоречащие закону взломы могут быть совершенно безнравственными, и наоборот — «существуют аморальные законы».

В своей новой книге Шнайер описывает хаки, большинство из которых технически законны, но противоречат интересам общества. При этом он уверен, что такими хаками особенно успешно занимаются богатые и влиятельные люди, в частности, правительства стран и главы крупных компаний. А от компьютерного хакинга до хакинга экономических, политических и социальных систем, по его мнению, всего один шаг. В своей новой книге он среди прочего рассказывает, что дети — прирожденные хакеры и без труда находят изъяны в разнообразных системах родительского и учительского контроля, объясняет, как беглые олигархи покупают недвижимость для взлома правовых систем и как противостоять «хакингу» со стороны пикаперов.

А от компьютерного хакинга до хакинга экономических, политических и социальных систем, по его мнению, всего один шаг. В своей новой книге он среди прочего рассказывает, что дети — прирожденные хакеры и без труда находят изъяны в разнообразных системах родительского и учительского контроля, объясняет, как беглые олигархи покупают недвижимость для взлома правовых систем и как противостоять «хакингу» со стороны пикаперов.

Книга «Взломать все. Как сильные мира сего используют уязвимости систем в своих интересах» выходит в русском переводе в июле в издательстве «Альпина Паблишер». Forbes публикует отрывок.

Проблема объяснимости

В книге «Автостопом по галактике» раса сверхразумных панпространственных существ создает самый мощный компьютер во вселенной — Думатель, Deep Thought («Глубокая мысль»), чтобы ответить на некий ключевой вопрос о жизни, Вселенной и всем сущем. После 7,5 млн лет вычислений Думатель сообщает, что ответ на главный вопрос бытия — «42». При этом он не в состоянии объяснить смысл этого ответа и даже не помнит, в чем, собственно, состоял сам вопрос.

После 7,5 млн лет вычислений Думатель сообщает, что ответ на главный вопрос бытия — «42». При этом он не в состоянии объяснить смысл этого ответа и даже не помнит, в чем, собственно, состоял сам вопрос.

Если в двух словах, то это и есть проблема объяснимости. Современные системы ИИ, по сути, являются черными ящиками: с одного конца в них поступают данные, с другого выходит ответ. Понять, как система пришла к тому или иному выводу, бывает невозможно, даже если вы являетесь ее разработчиком или имеете доступ к коду. Исследователи до сих пор не знают, как именно система классификации изображений ИИ отличает черепаху от винтовки, не говоря уже о том, почему она принимает одно за другое.

В 2016 году система искусственного интеллекта AlphaGo выиграла матч из пяти партий у одного из лучших в мире игроков Ли Седоля. Это потрясло как мир разработчиков ИИ, так и мир игроков в го. Тридцать седьмой ход AlphaGo, сделанный системой во второй партии, стал сенсацией. Объяснить весь его смысл, не углубляясь в стратегию го, будет трудно, но если вкратце, то это был ход, который не сделал бы ни один человек в мире. ИИ показал, что он мыслит иначе, чем мы.

Тридцать седьмой ход AlphaGo, сделанный системой во второй партии, стал сенсацией. Объяснить весь его смысл, не углубляясь в стратегию го, будет трудно, но если вкратце, то это был ход, который не сделал бы ни один человек в мире. ИИ показал, что он мыслит иначе, чем мы.

ИИ решает проблемы не так, как люди. Его ограничения отличаются от наших. Он рассматривает больше возможных решений, чем мы. И что еще важнее — он рассматривает больше типов решений. ИИ будет исследовать пути, которые мы в принципе не рассматриваем, пути более сложные, чем те, что обычно мы держим в уме. (Наши когнитивные ограничения на объем данных, которыми мы можем одновременно мысленно жонглировать, давно описаны как «магическое число семь плюс-минус два». У системы ИИ нет ничего даже отдаленно похожего на это ограничение.)

Материал по темеВ 2015 году исследовательская группа ввела в систему ИИ под названием Deep Patient медицинские данные примерно 700 000 человек с целью проверить, может ли она предсказывать развитие болезней.

Такое положение дел нельзя назвать идеальным. Система ИИ должна не просто выдавать ответы, но объяснять ход своих рассуждений в формате, понятном человеку. Это необходимо нам как минимум по двум причинам: чтобы доверять решениям ИИ и чтобы убедиться, что он не был хакнут с целью воздействия на его объективность. Аргументированное объяснение имеет и другую ценность, помимо того, что оно повышает вероятность точного ответа или принятия правильного решения: оно считается основным компонентом идеи надлежащей правовой процедуры в соответствии с законом.

Исследователи ИИ работают над проблемой объяснимости. В 2017 году Управление перспективных исследовательских проектов Министерства обороны США (DARPA) учредило исследовательский фонд в размере $75 млн для десятка программ в этой области. Потенциально это влияет на успех, но, похоже, нам не уйти от компромиссов между эффективностью и объяснимостью, между эффективностью и безопасностью и между объяснимостью и конфиденциальностью. Объяснения — это форма стенографии когнитивного процесса, используемая людьми и подходящая для наших методов принятия решений. Решения ИИ могут просто не соответствовать формату понятных для человека объяснений, а принуждение к ним систем ИИ может стать дополнительным ограничением, которое повлияет на качество принимаемых ими решений. Пока неясно, к чему приведут эти исследования. В ближайшей перспективе ИИ будет все более непрозрачным, поскольку системы усложняются, становясь все менее похожими на человека, а значит, и менее объяснимыми.

Впрочем, в некоторых контекстах мы можем не заботиться об объяснимости. Я был бы уверен в диагнозе, поставленном мне Deep Patient, даже если бы он не мог объяснить свои действия, но, согласно данным, ставил диагнозы точнее, чем врач-человек. Точно так же я мог бы относиться к системе ИИ, которая решает, где бурить нефтяные скважины, или предсказывает, какие детали самолета с большей вероятностью выйдут из строя. Но я бы не чувствовал себя так же комфортно в случае с непрозрачной системой ИИ, которая принимает решения о приеме в колледж, прогнозируя вероятность академических успехов абитуриента, с системой, которая принимает решения о выдаче кредита, учитывая расовые стереотипы в своих прогнозах возможной невыплаты, или с системой, принимающей решения об условно-досрочном освобождении на основе прогноза рецидивов. Возможно, некоторым людям даже спокойнее оттого, что системы ИИ принимают серьезные решения без объяснения причин.

Однако есть те, кто категорически не согласен с такой ситуацией и выступает против необъяснимого ИИ. Институт будущего жизни (FLI) и другие исследователи ИИ отмечают, что объяснимость особенно важна для систем, которые могут «причинить вред», оказать «существенное влияние на людей» или повлиять на «жизнь конкретного человека, ее качество или его репутацию». В докладе, озаглавленном «ИИ в Великобритании», говорится, что если система ИИ оказывает «существенное влияние на жизнь человека» и не может предоставить «полное и удовлетворительное объяснение» своих решений, то такую систему внедрять не следует.

На мой взгляд, разница между системой ИИ, которая предоставляет объяснение, и такой же системой, которая этого не делает, заключается в справедливости.

Без объяснимости можно легко получить результаты, подобные тем, которые генерирует внутренняя система ИИ компании Amazon для отбора заявлений о приеме на работу. Эта система была обучена на десятилетних данных о найме, и, поскольку в технологической отрасли доминируют мужчины, она научилась сексизму: оценивая резюме, система перемещала вниз те из них, в которых встречалось слово «женщина» или был указан женский колледж как место учебы. (Бывают случаи, когда мы не хотим, чтобы будущее было похоже на прошлое.)

Как только руководители Amazon осознали эту предвзятость и несправедливость, они потеряли к проекту интерес и в итоге отказались от использования системы. Они столкнулись с трудной, возможно, даже непреодолимой проблемой, поскольку существует множество противоречащих друг другу определений справедливости; то, что справедливо в одном контексте, не обязательно справедливо в другом. Какая система приема заявлений является справедливой? Та, которая не учитывает пол кандидата? Та, которая намеренно корректирует гендерные предубеждения? Та, которая распределяет квоты между представителями полов в той пропорции, в которой они подали заявления? Или та, которая обеспечивает равные возможности для разных полов?

Какая система приема заявлений является справедливой? Та, которая не учитывает пол кандидата? Та, которая намеренно корректирует гендерные предубеждения? Та, которая распределяет квоты между представителями полов в той пропорции, в которой они подали заявления? Или та, которая обеспечивает равные возможности для разных полов?

Если система ИИ сможет объяснить, чем она руководствовалась, давая ту или иную рекомендацию о приеме на работу или об условно-досрочном освобождении, мы сможем лучше проанализировать процесс принятия решений. Это означает, что мы с большей вероятностью будем доверять этой системе в ситуациях, которые имеют больше социальных нюансов, чем вопрос «Указывает ли этот рентген на опухоль?»

Материал по темеС другой стороны, сами человеческие решения не всегда объяснимы. Конечно, мы можем давать объяснения, но исследования показывают, что часто это скорее оправдания постфактум. Так что, возможно, ответ заключается в том, чтобы просто внимательно изучить результаты. Когда суды решают, является ли поведение того или иного полицейского департамента расистским, они не вскрывают черепа полицейских и не требуют от них объяснений своего поведения. Они смотрят на его результаты и на основании этого выносят решение.

Так что, возможно, ответ заключается в том, чтобы просто внимательно изучить результаты. Когда суды решают, является ли поведение того или иного полицейского департамента расистским, они не вскрывают черепа полицейских и не требуют от них объяснений своего поведения. Они смотрят на его результаты и на основании этого выносят решение.

Очеловечивание искусственного интеллекта

Системы искусственного интеллекта будут влиять на нас как на личном, так и на социальном уровне. Ранее я уже упоминал о социальной инженерии. Самые эффективные попытки фишинга — то есть те, в результате которых люди и компании теряют много денег — всегда персонализированны. Электронное письмо от имени генерального директора с просьбой о банковском переводе, адресованное кому-то из финансового отдела, может быть особенно эффективным, а голосовое или видеосообщение — тем паче. Трудоемкая задача настройки фишинговых атак может быть автоматизирована с помощью методов ИИ, что позволит мошенникам сделать электронные письма или голосовые сообщения от авторитетных лиц максимально правдоподобными.

Быть обманутым ИИ не обязательно означает, что вы получите больше проблем, чем от любого другого обмана. Настоящая опасность заключается в том, что ИИ сможет убеждать с компьютерной скоростью и масштабами. Сегодняшние когнитивные хаки — фейковая статья или провокационный вброс, способные одурачить лишь самых легковерных или отчаявшихся — покажутся топорной работой. ИИ обладает потенциалом для того, чтобы когнитивные хаки стали микроцелевыми: персонализированными, оптимизированными и доставляемыми непосредственно адресату. Есть много старых мошеннических трюков, учитывающих индивидуальные особенности жертвы. Рекламные сообщения — это когнитивные хаки массового поражения. Технологии ИИ способны объединить в себе и те и другие.

Люди уже давно приписывают компьютерным программам человеческие качества. В 1960-х годах программист Джозеф Вейценбаум создал примитивную разговорную программу ELIZA, которая имитировала манеру общения психотерапевта. Вейценбаум был поражен тем, что люди готовы делиться глубоко личными секретами с глупой компьютерной программой. Секретарша Вейценбаума даже просила его выйти из комнаты, чтобы она могла поговорить с ELIZA наедине. Сегодня мы наблюдаем, как люди стараются быть вежливыми с голосовыми помощниками, такими как Alexa и Siri, будто для них действительно важен тон общения. Siri даже жалуется, когда вы грубите ей. «Это не очень приятно», — говорит она, но лишь потому, что так запрограммирована.

Вейценбаум был поражен тем, что люди готовы делиться глубоко личными секретами с глупой компьютерной программой. Секретарша Вейценбаума даже просила его выйти из комнаты, чтобы она могла поговорить с ELIZA наедине. Сегодня мы наблюдаем, как люди стараются быть вежливыми с голосовыми помощниками, такими как Alexa и Siri, будто для них действительно важен тон общения. Siri даже жалуется, когда вы грубите ей. «Это не очень приятно», — говорит она, но лишь потому, что так запрограммирована.

Многочисленные эксперименты дают аналогичные результаты. Испытуемые оценивали производительность компьютера менее критично, если давали оценку в его присутствии, что свидетельствует об их подсознательном желании не ранить его чувства. В другом эксперименте, когда компьютер сообщал испытуемому явно вымышленную «личную информацию» о себе, тот, как правило, отвечал взаимностью, сообщая реальную личную информацию. Сила взаимности изучается сегодня психологами. Это еще один когнитивный хак, используемый людьми, который могут усилить масштаб и персонализация ИИ.

Это еще один когнитивный хак, используемый людьми, который могут усилить масштаб и персонализация ИИ.

Робототехника делает хакинг ИИ более эффективным. Люди освоили много способов узнавания самих себя в окружающем мире. Мы видим лица повсюду: две точки с горизонтальной черточкой под ними уже воспринимаются как лицо. Вот почему даже минималистичные иллюстрации так хорошо считываются нами. Если что-то имеет лицо, оно перестает быть чем-то и становится неким существом, со своими мыслями, чувствами и всем, что полагается настоящей личности. Если это некое существо говорит или, еще лучше, вступает с нами в диалог, то мы можем поверить, что у него есть намерения, желания и свобода действий. А если на его лице присутствуют еще и брови, то ничто не помешает нам в этом.

Роботы только подчеркивают эту человеческую уязвимость. Многие люди поддерживают квазисоциальные отношения со своими роботами-пылесосами и даже жалуются, если компания предлагает заменить, а не отремонтировать их. Армия США столкнулась с проблемой, когда полковник подразделения, где проходил тестирование новый противоминный робот, запретил насекомообразному устройству продолжать наносить себе вред, наступая на мины. Робот, разработанный в Гарварде, смог убедить студентов впустить его в кампус, притворившись доставщиком пиццы. А Boxie — говорящий робот, похожий на ребенка, разработанный в стенах MIT — способен убеждать людей отвечать на личные вопросы, просто вежливо их попросив.

Многие люди поддерживают квазисоциальные отношения со своими роботами-пылесосами и даже жалуются, если компания предлагает заменить, а не отремонтировать их. Армия США столкнулась с проблемой, когда полковник подразделения, где проходил тестирование новый противоминный робот, запретил насекомообразному устройству продолжать наносить себе вред, наступая на мины. Робот, разработанный в Гарварде, смог убедить студентов впустить его в кампус, притворившись доставщиком пиццы. А Boxie — говорящий робот, похожий на ребенка, разработанный в стенах MIT — способен убеждать людей отвечать на личные вопросы, просто вежливо их попросив.

Наша реакция на некоторых роботов в чем-то схожа с нашим восприятием детей. У детей большие головы относительно тела, большие глаза относительно головы, большие ресницы относительно глаз и высокие голоса. Мы реагируем на эти характеристики инстинктивным желанием защитить.

Художники из поколения в поколение использовали этот феномен, чтобы придать своим творениям симпатичный вид. Детские куклы призваны вызывать чувство любви и заботы. Герои многих мультфильмов, включая Бетти Буп (1930-е) и Бэмби (1942), нарисованы по такому шаблону. Главной героине научно-фантастического боевика «Алита: Боевой ангел» (2019 год) с помощью компьютерной графики увеличили глаза, чтобы они казались больше.

Детские куклы призваны вызывать чувство любви и заботы. Герои многих мультфильмов, включая Бетти Буп (1930-е) и Бэмби (1942), нарисованы по такому шаблону. Главной героине научно-фантастического боевика «Алита: Боевой ангел» (2019 год) с помощью компьютерной графики увеличили глаза, чтобы они казались больше.

В 2016 году Технологический институт Джорджии опубликовал исследование о доверии человека к роботам, в котором неантропоморфный робот помогал участникам перемещаться по зданию, давая указания типа «Это путь к выходу». Сначала участники взаимодействовали с роботом в обычной обстановке, чтобы оценить его эффективность, которая была специально занижена. Затем они должны были решить, следовать или нет советам робота в условиях смоделированной чрезвычайной ситуации. Поразительно, но все 26 участников послушались его указаний, несмотря на то, что всего за несколько минут до этого убедились в его плохих навигационных навыках. Степень доверия к машине была вне всякой логики: когда робот указал на темную комнату без четко обозначенного выхода, большинство людей послушались его, вместо того чтобы просто и безопасно покинуть здание через дверь, в которую они вошли. Исследователи провели аналогичные эксперименты с другими роботами, явно имитировавшими неисправность. И вновь испытуемые вопреки здравому смыслу последовали экстренным указаниям роботов. Похоже, роботы могут естественным образом взламывать наше доверие.

Степень доверия к машине была вне всякой логики: когда робот указал на темную комнату без четко обозначенного выхода, большинство людей послушались его, вместо того чтобы просто и безопасно покинуть здание через дверь, в которую они вошли. Исследователи провели аналогичные эксперименты с другими роботами, явно имитировавшими неисправность. И вновь испытуемые вопреки здравому смыслу последовали экстренным указаниям роботов. Похоже, роботы могут естественным образом взламывать наше доверие.

Антропоморфные роботы — это еще более убедительная в эмоциональном плане технология, а ИИ только усилит ее привлекательность. Поскольку ИИ все лучше имитирует людей и животных, постепенно он захватит все механизмы, которые мы используем для оценки друг друга. Как писала психолог Шерри Теркл, «когда роботы устанавливают зрительный контакт, узнают лица, повторяют человеческие жесты, они нажимают на наши дарвиновские кнопки, демонстрируя поведение, которое люди связывают с разумом, намерениями и эмоциями». Проще говоря, они хакают наш мозг.

Проще говоря, они хакают наш мозг.

Мы не просто будем относиться к системам ИИ как к людям. Они будут вести себя как люди, причем намеренно обманывая нас. Они прибегнут к когнитивному хакингу.

Ирландия запускает расследование по защите данных в связи со взломом Facebook

Facebook заявил, что взлом произошел до сентября 2019 года. — Авторские права Фото AP/Ричард Дрю, файлАвтор: Мэтью Холройд

На прошлой неделе на хакерском форуме были обнаружены личные данные более 530 миллионов пользователей Facebook.

Орган по защите данных Ирландии начал расследование в отношении Facebook в связи с утечкой личных данных.

Личные данные более 530 миллионов пользователей Facebook были обнаружены на сайте для хакеров на прошлой неделе.

По данным исследовательской компании Hudson Rock, занимающейся киберпреступностью, номера телефонов, адресов электронной почты и даты рождения 533 миллионов учетных записей Facebook были скомпрометированы.

Сообщается, что пострадали пользователи из 106 стран, в том числе более 35 миллионов учетных записей в Италии и почти 20 миллионов учетных записей во Франции.

В среду Комиссия по защите данных Ирландии подтвердила, что они расследуют, были ли нарушены права на личные данные в Европейском союзе.

«DPC связался с Facebook Ireland в связи с этой проблемой, о которой сообщалось, и поднял вопросы относительно соответствия GDPR, на которые Facebook Ireland предоставила ряд ответов», — говорится в заявлении ведомства.

Facebook признал утечку данных, заявив, что ответственность за это несут «злоумышленники», но заявил, что утечка не нова.

«Мы считаем, что данные, о которых идет речь, были извлечены из профилей пользователей Facebook злоумышленниками с помощью нашего средства импорта контактов до сентября 2019 года», — сказал Майк Кларк, директор по управлению продуктами Facebook.

«Эта функция была разработана, чтобы помочь людям легко находить своих друзей для связи в наших службах, используя свои списки контактов.»

Facebook добавил, что взломанный материал не содержал финансовой информации, медицинской информации или паролей, и заявил, что они приняли меры для предотвращения подобных нарушений в будущем.

«В результате предпринятых нами действий мы уверены, что конкретная проблема, которая позволила им собрать эти данные в 2019 году, больше не существует», — говорится в заявлении Кларка.

Однако платформу широко критиковали за то, что она не извинилась за взлом и не извлекла уроков из предыдущих взломов. Неясно, уведомил ли Facebook пострадавших пользователей в то время.

Комиссия по защите данных Ирландии первоначально заявила, что работает над установлением всех фактов инцидента, чтобы проверить, действительно ли он был в 2019 году., и добавили, что не получали никаких активных сообщений от Facebook.

Поскольку европейская штаб-квартира Facebook находится в Дублине, компания подчиняется Ирландской комиссии по защите данных в Европейском союзе.

Репутация социальной сети была запятнана в 2018 году скандалом с Cambridge Analytica, когда британская фирма похитила личные данные до 87 миллионов пользователей Facebook в целях политической пропаганды.

Facebook еще не прокомментировал последний запрос.

Регулятор данных Ирландии оштрафовал Meta на 17 миллионов евро за нарушение законов о защите данных

Facebook оштрафован на 7 миллионов евро в Италии за «вводящие в заблуждение» методы работы с данными

Турция расследует WhatsApp и Facebook из-за обновления конфиденциальности данных

Защита данных Фейсбук Взлом Социальные медиа Ирландия

с отличием

с отличием- Русский

- Китайский

- Английский

- испанский

- Международный

- Обзор

- Департаменты

- Познакомьтесь с Санкт-Петербургом

- Отзывы

- партнерство

- Обзор

- Ассоциации

- Исследовательские и образовательные партнеры

- Инновации

- Обзор

- Поддержка инноваций

- Исследовать

- Обзор

- Исследовательские подразделения

- Библиотеки и открытые данные

- Совместное исследование ИТМО

- аспирант

- О нас

- С одного взгляда

- Лидерство

- Структура университета

- Команда университета

- Международный совет

- История и награды

- История

- Награды

- Почетные профессора

В 2004, 2008, 2009, 2012, 2013, 2015 и 2017 годах команда Университета ИТМО занимала первые места в ACM World Programming Contest. На данный момент наша команда является единственным в мире семикратным чемпионом ACM ICPC.

На данный момент наша команда является единственным в мире семикратным чемпионом ACM ICPC.

Другие последние победы команды Университета ИТМО:

Хэш-код Google 2018, первое место (Ирландия)

ACM International Collegiate Programming Contest, третье место (Китай)

Moscow Travel Hack, первое место (Россия)

Хакатон ВКонтакте 2019, первое место (Россия)

Кубок чести Huawei, первое место (Россия)

Кубок ВК 2018, 1 место (Россия)

CTF Кубок России, 1 место (Россия)

РобоКубок 2019, второе место (Австралия)

Robot Challenge 2018, первое место (Китай)

RoboCup Asia-Pacific 2017, второе место (Таиланд)

Robotex 2017, первое место (Эстония)

Всемирная олимпиада роботов 2017, первое место (Коста-Рика)

Национальная олимпиада по робототехнике, первое место (Россия)

Престижные международные награды

- В июле 2020 года две работы ученых Университета ИТМО были отмечены наградами на престижной конференции по эволюционным вычислениям GECCO 2020.

В этой номинации бронзовую медаль получила команда, в которую вошли представители Университета ИТМО Екатерина Носкова, Владимир Ульянцев, Стивен О’Брайен и Павел Добрынин. Другая команда исследователей, в которую вошли Денис Антипов и Максим Буздалов, получила приз за лучшую работу в своей области.

В этой номинации бронзовую медаль получила команда, в которую вошли представители Университета ИТМО Екатерина Носкова, Владимир Ульянцев, Стивен О’Брайен и Павел Добрынин. Другая команда исследователей, в которую вошли Денис Антипов и Максим Буздалов, получила приз за лучшую работу в своей области. - В сентябре 2019 года профессор Университета ИТМО Владимир Дубровский был удостоен звания кавалера ордена Академических пальм — одной из высших наград Французской Республики в области науки и образования.

- В сентябре 2018 года профессор Кластера биохимии Университета ИТМО Екатерина Скорб получила стипендию L’Oréal-UNESCO за выдающийся вклад в науку.

- В июле 2018 года два сотрудника Международного научно-образовательного центра нанофотоники и метаматериалов ИТМО, аспирант Тель-Авивского университета Дмитрий Филонов и аспирант Университета ИТМО Алена Щелокова, получили престижную награду IEEE Photonics Society Graduate Student Fellowship Award, присуждаемую выдающимся аспирантам за их передовые исследования.

В этой номинации бронзовую медаль получила команда, в которую вошли представители Университета ИТМО Екатерина Носкова, Владимир Ульянцев, Стивен О’Брайен и Павел Добрынин. Другая команда исследователей, в которую вошли Денис Антипов и Максим Буздалов, получила приз за лучшую работу в своей области.

В этой номинации бронзовую медаль получила команда, в которую вошли представители Университета ИТМО Екатерина Носкова, Владимир Ульянцев, Стивен О’Брайен и Павел Добрынин. Другая команда исследователей, в которую вошли Денис Антипов и Максим Буздалов, получила приз за лучшую работу в своей области.