Распознавание лиц и силуэтов людей, автомобилей и номерных знаков

Что мы делаем

NtechLab — мировой лидер в области решений для видеоаналитики. Наша технология, построенная на базе искусственного интеллекта и биометрической идентификации, обеспечивает распознавание лиц и силуэтов, объектов и автомобилей, а также действий с целью решения широкого спектра задач как для крупного и среднего бизнеса, так и для создания масштабных проектов на уровне городов и регионов.

ПОДБЕРИТЕ РЕШЕНИЕ

ДЛЯ БИЗНЕСА

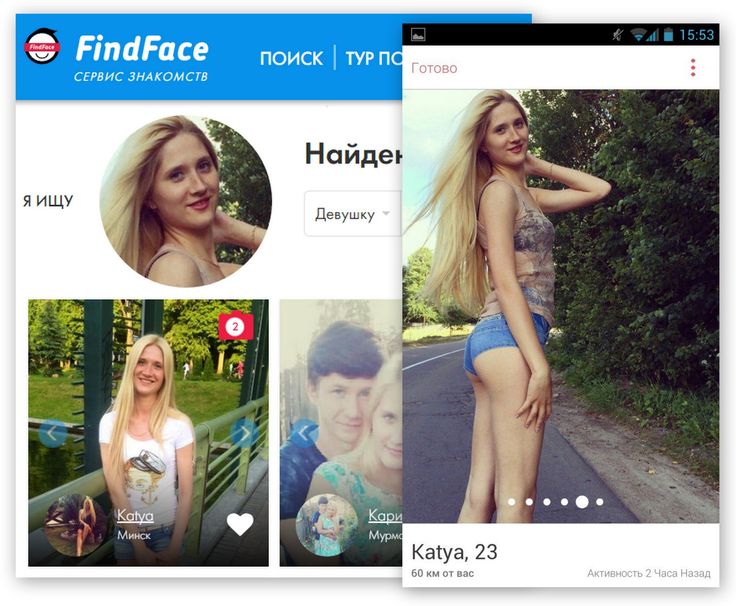

Используйте возможности FindFace в вашей индустрии

РОЗНИЧНАЯ ТОРГОВЛЯ | ФИНАНСОВЫЕ ОРГАНИЗАЦИИ | КОРПОРАТИВНАЯ БЕЗОПАСНОСТЬ | ИНДУСТРИЯ РАЗВЛЕЧЕНИЙ | ОНЛАЙН-СЕРВИСЫ И МОБИЛЬНЫЕ ПРИЛОЖЕНИЯ

ДЛЯ ГОСУДАРСТВА

№ 1 в области биометрических решений

для общественной безопасности

ОБЩЕСТВЕННАЯ БЕЗОПАСНОСТЬ | ТРАНСПОРТНАЯ БЕЗОПАСНОСТЬ | БИОМЕТРИЧЕСКИЙ КОМПЛЕКС | ОБРАЗОВАТЕЛЬНЫЕ УЧРЕЖДЕНИЯ | ANTI-COVID-19

ВЫБЕРИТЕ СЦЕНАРИЙ ИСПОЛЬЗОВАНИЯ FINDFACEМировое признаниеНаши алгоритмы распознавания лиц, силуэтов, автомобилей и других объектов признаны лучшими по данным авторитетных международных конкурсов, академических и коммерческих исследовательских тестов.

РАСПОЗНАВАНИЕ ЛИЦА

Обнаружение людей при работе с тысячами камер в режиме реального времени

Высочайшая скорость и точность верификации лиц даже при работе с базами в миллиард лиц и тысячами камер

Пол, возраст, эмоции, очки, борода, защитная маска

РАСПОЗНАВАНИЕ СИЛУЭТА

Алгоритм распознавания силуэтов NtechLab входит в тройку мировых лидеров

Программа распознавания лиц детектирует силуэты неограниченного числа людей

Система распознавания людей позволяет отслеживать силуэты сразу с нескольких камер видеонаблюдения

РАСПОЗНАВАНИЕ АВТОМОБИЛЯ И НОМЕРА

Умные автомобильные пропускные пункты, отслеживание перемещений автомобилей по городу или по территории объекта

Определение марки, модели, цвета и типа кузова легковых автомобилей

Выявление и анализ связей между идентификацией человека и идентификацией автомобиля

—ОТПРАВИТЬ ЗАПРОС

НА ПРОБНУЮ ВЕРСИЮ

Заполните форму, чтобы получить доступ к демо-версии FindFace

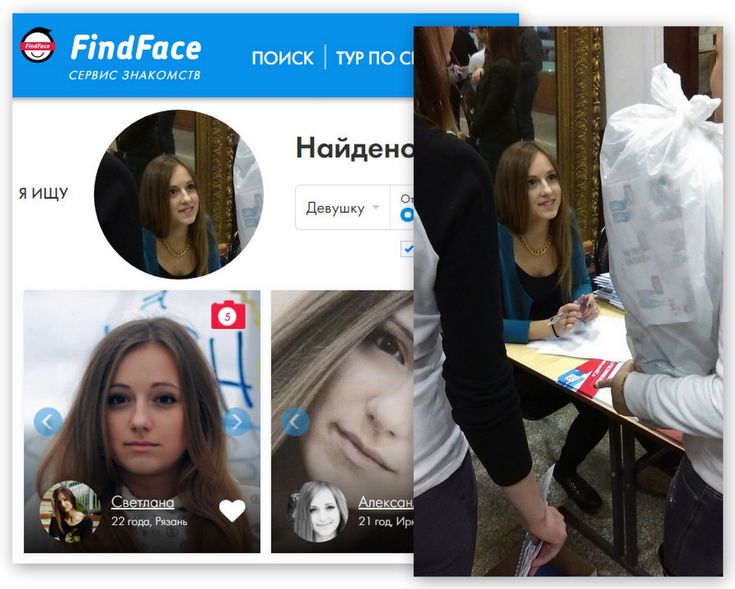

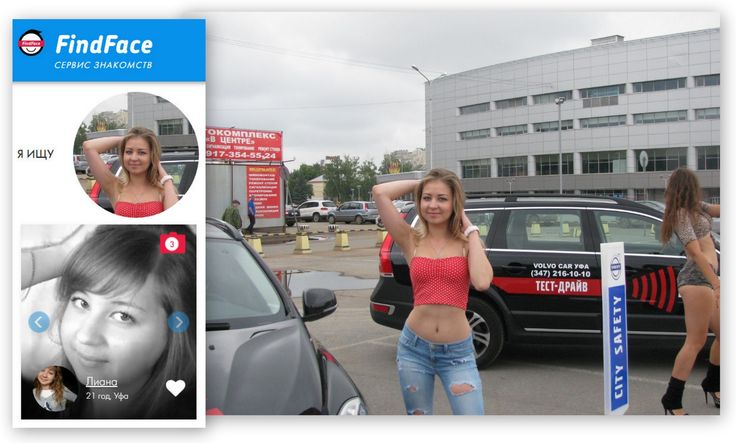

О НАС ПИШУТ ВЕДУЩИЕ МИРОВЫЕ ИЗДАНИЯFindFace — высокоточный механизм распознавания лиц, выдающийся даже по меркам страны, известной своими космическими технологиями.

Это не единственная фирма, развивающая технологию распознавания лиц, но точно одна из самых передовых. Национальный институт стандартов и технологий Правительства США недавно определил, что NtechLab обладает одной из самых точных систем распознавания лиц в мире.

Программа распознавания лиц на фото и видео FindFace превосходит лучшие программы распознавания лиц Google и Китая.

Алгоритм NtechLab превзошел программное обеспечение Google по распознаванию лица в MegaFace, техническом соревновании, организованном Вашингтонским университетом.

NtechLab, одна из ведущих мировых компаний, специализирующихся на распознавании лиц, стремится удовлетворить растущие потребности в этой технологии у крупных предприятий.

В 2018 году Национальный технологический институт США (NIST) отметил технологическое превосходство NtechLab в надежности и мощи программного обеспечения.

FindFace — высокоточный механизм распознавания лиц, выдающийся даже по меркам страны, известной своими космическими технологиями.

Это не единственная фирма, развивающая технологию распознавания лиц, но точно одна из самых передовых. Национальный институт стандартов и технологий Правительства США недавно определил, что NtechLab обладает одной из самых точных систем распознавания лиц в мире.

Программа распознавания лиц на фото и видео FindFace превосходит лучшие программы распознавания лиц Google и Китая.

Алгоритм NtechLab превзошел программное обеспечение Google по распознаванию лица в MegaFace, техническом соревновании, организованном Вашингтонским университетом.

NtechLab, одна из ведущих мировых компаний, специализирующихся на распознавании лиц, стремится удовлетворить растущие потребности в этой технологии у крупных предприятий.

В 2018 году Национальный технологический институт США (NIST) отметил технологическое превосходство NtechLab в надежности и мощи программного обеспечения.

Расовая дискриминация в технологии распознавания лиц

Автор Alex Najibi

Мы разблокируем наши iPhone одним взглядом и удивляемся, как Facebook смог отметить нас на этой фотографии. Но распознавание лиц, технология, лежащая в основе этих функций, — это больше, чем просто уловка. Он используется для наблюдения правоохранительных органов, досмотра пассажиров в аэропортах, а также для принятия решений о трудоустройстве и жилье. Несмотря на широкое распространение, распознавание лиц недавно было запрещено для использования полицией и местными агентствами в нескольких городах, включая Бостон и Сан-Франциско. Почему? Из основных используемых биометрических данных (отпечаток пальца, радужная оболочка глаза, ладонь, голос и лицо) распознавание лиц является наименее точным и сопряжено с проблемами конфиденциальности.

Но распознавание лиц, технология, лежащая в основе этих функций, — это больше, чем просто уловка. Он используется для наблюдения правоохранительных органов, досмотра пассажиров в аэропортах, а также для принятия решений о трудоустройстве и жилье. Несмотря на широкое распространение, распознавание лиц недавно было запрещено для использования полицией и местными агентствами в нескольких городах, включая Бостон и Сан-Франциско. Почему? Из основных используемых биометрических данных (отпечаток пальца, радужная оболочка глаза, ладонь, голос и лицо) распознавание лиц является наименее точным и сопряжено с проблемами конфиденциальности.

Полиция использует распознавание лиц, чтобы сравнивать фотографии подозреваемых с фотоснимками и изображениями на водительских правах; по оценкам, почти половина взрослых американцев — более 117 миллионов человек по состоянию на 2016 год — имеют фотографии в сети распознавания лиц, используемой правоохранительными органами. Это участие происходит без согласия или даже осознания, и поддерживается отсутствием законодательного надзора. Однако еще более тревожным является то, что нынешнее внедрение этих технологий сопряжено со значительными расовыми предубеждениями, особенно в отношении чернокожих американцев. Даже если распознавание лиц является точным, оно расширяет возможности правоохранительной системы с долгой историей расистской и антиактивистской слежки и может увеличить ранее существовавшее неравенство.

Однако еще более тревожным является то, что нынешнее внедрение этих технологий сопряжено со значительными расовыми предубеждениями, особенно в отношении чернокожих американцев. Даже если распознавание лиц является точным, оно расширяет возможности правоохранительной системы с долгой историей расистской и антиактивистской слежки и может увеличить ранее существовавшее неравенство.

Алгоритмы распознавания лиц отличаются высокой точностью классификации (более 90%), но эти результаты не универсальны. Растущее количество исследований выявляет различные показатели ошибок в демографических группах, при этом наименьшая точность постоянно обнаруживается у женщин, чернокожих и в возрасте 18–30 лет. В знаковом проекте 2018 года «Гендерные оттенки» межсекционный подход был применен для оценки трех алгоритмов гендерной классификации, в том числе разработанных IBM и Microsoft. Испытуемых разделили на четыре категории: темнокожие женщины, темнокожие мужчины, светлокожие женщины и светлокожие мужчины. Все три алгоритма показали наихудшие результаты на темнокожих женщинах, с частотой ошибок до 34% выше, чем у светлокожих мужчин (Рисунок 1) . Независимая оценка Национального института стандартов и технологий (NIST) подтвердила эти исследования, обнаружив, что технологии распознавания лиц по 189 алгоритмам наименее точны для цветных женщин.

Все три алгоритма показали наихудшие результаты на темнокожих женщинах, с частотой ошибок до 34% выше, чем у светлокожих мужчин (Рисунок 1) . Независимая оценка Национального института стандартов и технологий (NIST) подтвердила эти исследования, обнаружив, что технологии распознавания лиц по 189 алгоритмам наименее точны для цветных женщин.

Эти убедительные результаты вызвали немедленную реакцию, сформировав непрерывный дискурс о справедливости в распознавании лиц. IBM и Microsoft объявили о мерах по снижению предвзятости путем изменения групп тестирования и улучшения сбора данных по конкретным демографическим показателям. Повторный аудит Gender Shades подтвердил снижение частоты ошибок для чернокожих женщин и исследовал больше алгоритмов, включая Rekognition от Amazon, который также показал расовую предвзятость в отношении темнокожих женщин (ошибка 31% в гендерной классификации). Этот результат подтвердил более раннюю оценку возможностей Rekognition по сопоставлению лиц, проведенную Американским союзом гражданских свобод (ACLU), в которой 28 членов Конгресса, непропорционально цветных людей, были неправильно сопоставлены с фотографиями. Однако ответы Amazon носили оборонительный характер, заявляя о проблемах с методологией аудиторов, а не о расовой предвзятости. Поскольку Amazon продала свою технологию правоохранительным органам, эти несоответствия вызывают обеспокоенность. Компании, которые предоставляют эти услуги, несут ответственность за то, чтобы они были справедливыми — как в своих технологиях, так и в своих приложениях.

Повторный аудит Gender Shades подтвердил снижение частоты ошибок для чернокожих женщин и исследовал больше алгоритмов, включая Rekognition от Amazon, который также показал расовую предвзятость в отношении темнокожих женщин (ошибка 31% в гендерной классификации). Этот результат подтвердил более раннюю оценку возможностей Rekognition по сопоставлению лиц, проведенную Американским союзом гражданских свобод (ACLU), в которой 28 членов Конгресса, непропорционально цветных людей, были неправильно сопоставлены с фотографиями. Однако ответы Amazon носили оборонительный характер, заявляя о проблемах с методологией аудиторов, а не о расовой предвзятости. Поскольку Amazon продала свою технологию правоохранительным органам, эти несоответствия вызывают обеспокоенность. Компании, которые предоставляют эти услуги, несут ответственность за то, чтобы они были справедливыми — как в своих технологиях, так и в своих приложениях.

Другой ключевой источник расовой дискриминации при распознавании лиц заключается в его использовании. В 18 веке в Нью-Йорке «законы о фонарях» требовали, чтобы порабощенные люди носили фонари после наступления темноты, чтобы быть на виду у публики. Сторонники опасаются, что даже если алгоритмы распознавания лиц станут справедливыми, технологии могут применяться в том же духе, нанося несоразмерный вред чернокожему сообществу в соответствии с существующими расистскими моделями правоохранительных органов. Кроме того, распознавание лиц потенциально может быть нацелено на другие маргинализированные группы населения, такие как иммигранты без документов, согласно ICE, или граждане-мусульмане, согласно NYPD.

В 18 веке в Нью-Йорке «законы о фонарях» требовали, чтобы порабощенные люди носили фонари после наступления темноты, чтобы быть на виду у публики. Сторонники опасаются, что даже если алгоритмы распознавания лиц станут справедливыми, технологии могут применяться в том же духе, нанося несоразмерный вред чернокожему сообществу в соответствии с существующими расистскими моделями правоохранительных органов. Кроме того, распознавание лиц потенциально может быть нацелено на другие маргинализированные группы населения, такие как иммигранты без документов, согласно ICE, или граждане-мусульмане, согласно NYPD.

После убийства Джорджа Флойда полицией Миннеаполиса были отмечены дискриминационные действия правоохранительных органов. У чернокожих американцев больше шансов быть арестованными и заключенными в тюрьму за мелкие преступления, чем у белых. Следовательно, чернокожие чрезмерно представлены в данных фотоснимков, которые распознавание лиц использует для прогнозирования. Присутствие чернокожих в таких системах создает петлю обратной связи, в результате которой расистские полицейские стратегии приводят к непропорциональным арестам чернокожих, которые затем подлежат слежке в будущем. Например, полиция Нью-Йорка ведет базу данных о 42 000 «аффилированных с бандами» — 99% чернокожих и латиноамериканцев — без требований доказывать предполагаемую принадлежность к банде. Фактически, некоторые полицейские управления используют идентификацию члена банды как меру производительности, поощряя ложные сообщения. Для участников включение в эти базы данных мониторинга может привести к более суровому приговору и увеличению размера залога или полному отказу в освобождении под залог.

Например, полиция Нью-Йорка ведет базу данных о 42 000 «аффилированных с бандами» — 99% чернокожих и латиноамериканцев — без требований доказывать предполагаемую принадлежность к банде. Фактически, некоторые полицейские управления используют идентификацию члена банды как меру производительности, поощряя ложные сообщения. Для участников включение в эти базы данных мониторинга может привести к более суровому приговору и увеличению размера залога или полному отказу в освобождении под залог.

Но как именно несправедливые приложения распознавания лиц и наблюдения вредят чернокожим американцам? Как заявила Алгоритмическая Лига Справедливости, «наблюдение за лицом угрожает правам, включая неприкосновенность частной жизни, свободу выражения мнений, свободу ассоциаций и надлежащую правовую процедуру». Слежка связана с поведенческими изменениями, включая самоцензуру и избегание активности из страха возмездия; например, распознавание лиц использовалось для отслеживания и идентификации протестующих Black Lives Matter. ФБР имеет долгую историю слежки за известными чернокожими активистами и лидерами, чтобы отслеживать и пресекать их усилия. Кроме того, постоянное наблюдение вызывает страх и психологический вред, делая субъектов уязвимыми для целенаправленных злоупотреблений, а также физического вреда за счет расширения систем государственного надзора, используемых для отказа в доступе к здравоохранению и социальному обеспечению. В системе уголовного правосудия технологии распознавания лиц, точность которых по своей природе необъективна, могут ошибочно идентифицировать подозреваемых и заключать в тюрьму невиновных чернокожих американцев.

ФБР имеет долгую историю слежки за известными чернокожими активистами и лидерами, чтобы отслеживать и пресекать их усилия. Кроме того, постоянное наблюдение вызывает страх и психологический вред, делая субъектов уязвимыми для целенаправленных злоупотреблений, а также физического вреда за счет расширения систем государственного надзора, используемых для отказа в доступе к здравоохранению и социальному обеспечению. В системе уголовного правосудия технологии распознавания лиц, точность которых по своей природе необъективна, могут ошибочно идентифицировать подозреваемых и заключать в тюрьму невиновных чернокожих американцев.

В качестве яркого примера можно привести модельную программу наблюдения Project Green Light (PGL), которая была введена в действие в 2016 году и предусматривала установку камер высокой четкости по всему городу Детройт. Данные, которые передаются непосредственно в Детройтское управление полиции, могут быть проверены на распознавание лиц по криминальным базам данных, водительским правам и фотографиям, удостоверяющим личность; почти каждый житель Мичигана состоит в этой системе. Но станции PGL распределены неравномерно: наблюдение коррелирует с районами с преобладанием чернокожих, избегая белых и азиатских анклавов (Рисунок 2) . При опросе жителей критический анализ PGL сообщил в 2019 году, что «наблюдение и сбор данных были тесно связаны с перенаправлением общественных пособий, небезопасным жильем, потерей возможностей трудоустройства, а также охраной и последующей криминализацией членов сообщества, которые вступают в контакт с эти системы наблюдения». PGL иллюстрирует, как системы мониторинга лиц могут увековечить расовое неравенство, если их применение не регулируется.

Но станции PGL распределены неравномерно: наблюдение коррелирует с районами с преобладанием чернокожих, избегая белых и азиатских анклавов (Рисунок 2) . При опросе жителей критический анализ PGL сообщил в 2019 году, что «наблюдение и сбор данных были тесно связаны с перенаправлением общественных пособий, небезопасным жильем, потерей возможностей трудоустройства, а также охраной и последующей криминализацией членов сообщества, которые вступают в контакт с эти системы наблюдения». PGL иллюстрирует, как системы мониторинга лиц могут увековечить расовое неравенство, если их применение не регулируется.

Для устранения этого неравенства используются несколько способов. Некоторые нацелены на техническую алгоритмическую производительность. Во-первых, алгоритмы могут обучаться на разнообразных и репрезентативных наборах данных, поскольку стандартные обучающие базы данных в основном состоят из белых и мужчин. Включение в эти наборы данных должно требовать согласия каждого человека. Во-вторых, источники данных (фотографии) можно сделать более объективными. Настройки камеры по умолчанию часто не оптимизированы для захвата более темных тонов кожи, что приводит к более низкому качеству изображений чернокожих американцев из базы данных. Установление стандартов качества изображения для распознавания лиц и настроек для фотографирования черных объектов может уменьшить этот эффект. В-третьих, для оценки эффективности регулярный и этический аудит, особенно с учетом пересекающихся идентичностей (например, молодых, темнокожих и женщин), проводимый NIST или другими независимыми источниками, может привлечь компании, занимающиеся распознаванием лиц, к ответственности за оставшиеся методологические предубеждения.

Некоторые нацелены на техническую алгоритмическую производительность. Во-первых, алгоритмы могут обучаться на разнообразных и репрезентативных наборах данных, поскольку стандартные обучающие базы данных в основном состоят из белых и мужчин. Включение в эти наборы данных должно требовать согласия каждого человека. Во-вторых, источники данных (фотографии) можно сделать более объективными. Настройки камеры по умолчанию часто не оптимизированы для захвата более темных тонов кожи, что приводит к более низкому качеству изображений чернокожих американцев из базы данных. Установление стандартов качества изображения для распознавания лиц и настроек для фотографирования черных объектов может уменьшить этот эффект. В-третьих, для оценки эффективности регулярный и этический аудит, особенно с учетом пересекающихся идентичностей (например, молодых, темнокожих и женщин), проводимый NIST или другими независимыми источниками, может привлечь компании, занимающиеся распознаванием лиц, к ответственности за оставшиеся методологические предубеждения.

Другие подходы нацелены на настройку приложения. Законодательство может контролировать использование технологии распознавания лиц, так как даже если алгоритмы распознавания лиц будут абсолютно точными, их вклад в массовую слежку и выборочное применение против расовых меньшинств должен быть ограничен. Несколько групп защиты взаимодействуют с законодателями, обучая расовой грамотности распознаванию лиц и требуя от производителей подотчетности и прозрачности. Например, Safe Face Pledge призывает организации устранить предвзятость в своих технологиях и оценить их применение. Такие усилия уже достигли определенного прогресса. 2019Закон об алгоритмической подотчетности уполномочил Федеральную торговую комиссию регулировать компании, введя обязательства по оценке алгоритмического обучения, точности и конфиденциальности данных. Кроме того, на нескольких слушаниях в Конгрессе специально рассматривалась дискриминация чернокожих при распознавании лиц. Мощные протесты после убийства Джорджа Флойда также привели к значительным изменениям. Демократы Конгресса представили законопроект о реформе полиции, содержащий положения, ограничивающие использование технологий распознавания лиц. Еще более удивительным был ответ со стороны технических специалистов: IBM прекратила выпуск своей системы, Amazon объявила о приостановке на один год использования Rekognition полицией, а Microsoft приостановила продажу своей технологии распознавания лиц полиции до тех пор, пока не будут приняты федеральные правила. Эти достижения поддержали призывы к более прогрессивному законодательству, например, движения за реформирование или упразднение полиции. На данный момент движение за справедливое распознавание лиц переплетается с движением за справедливую систему уголовного правосудия.

Демократы Конгресса представили законопроект о реформе полиции, содержащий положения, ограничивающие использование технологий распознавания лиц. Еще более удивительным был ответ со стороны технических специалистов: IBM прекратила выпуск своей системы, Amazon объявила о приостановке на один год использования Rekognition полицией, а Microsoft приостановила продажу своей технологии распознавания лиц полиции до тех пор, пока не будут приняты федеральные правила. Эти достижения поддержали призывы к более прогрессивному законодательству, например, движения за реформирование или упразднение полиции. На данный момент движение за справедливое распознавание лиц переплетается с движением за справедливую систему уголовного правосудия.

Распознавание лиц остается мощной технологией, имеющей большое значение как в уголовном правосудии, так и в повседневной жизни. Существуют менее спорные приложения распознавания лиц, например вспомогательные технологии, поддерживающие людей с нарушениями зрения. Хотя в этой статье мы уделяем особое внимание распознаванию лиц, обсуждаемые проблемы и решения являются частью более широких усилий по выявлению и устранению неравенства в областях искусственного интеллекта и машинного обучения. Поэтому в следующий раз, когда мы разблокируем наш телефон, давайте вспомним, что устранение расовой предвзятости в распознавании лиц и его приложениях необходимо, чтобы сделать эти алгоритмы справедливыми и еще более эффективными.

Хотя в этой статье мы уделяем особое внимание распознаванию лиц, обсуждаемые проблемы и решения являются частью более широких усилий по выявлению и устранению неравенства в областях искусственного интеллекта и машинного обучения. Поэтому в следующий раз, когда мы разблокируем наш телефон, давайте вспомним, что устранение расовой предвзятости в распознавании лиц и его приложениях необходимо, чтобы сделать эти алгоритмы справедливыми и еще более эффективными.

Алекс Наджиби — доктор философии 5-го года обучения. кандидат биоинженерии в Школе инженерии и прикладных наук Гарвардского университета .

Для получения дополнительной информации:- Узнайте больше о распознавании лиц в системе уголовного правосудия здесь

- Прочтите эту статью, в которой обсуждается, как мы можем привлечь ИИ к ответственности. правоохранительными органами США

- Ознакомьтесь с исследованием различий в точности распознавания лиц в рамках проекта Gender Shades

Эта статья является частью нашего специального выпуска, посвященного научной политике и социальной справедливости.

Распознавание лиц слишком предвзято, чтобы его можно было отпустить?

Столичная полиция в Лондоне использовала камеры распознавания лиц для поиска разыскиваемых людей в феврале. Фото: Кельвин Чан / AP / Shutterstock

Когда столичная полиция Лондона тестировала технологию распознавания лиц в режиме реального времени в период с 2016 по 2019 год., они пригласили Дара Мюррея наблюдать за некоторыми судебными процессами из диспетчерской внутри полицейского фургона.

«Это как в кино, — говорит Мюррей, юрист из Университета Эссекса в Колчестере, Великобритания. Когда камеры сканировали прохожих в торговых центрах или на общественных площадях, они передавали изображения на компьютер внутри фургона. Мюррей и полицейские видели, как программное обеспечение рисовало прямоугольники вокруг лиц, идентифицируя их в прямом эфире. Затем он извлек ключевые характеристики и сравнил их с подозреваемыми из списка наблюдения. «Если есть совпадение, он извлекает изображение из прямой трансляции вместе с изображением из списка наблюдения».

Скотленд-Ярд, как иногда называют штаб-квартиру лондонской полиции, поручил Мюррею и его коллеге из Эссексского университета Питу Фасси, социологу, провести независимое исследование своей сети. Но их результаты 1 , опубликованные в июле 2019 года, возможно, оказались не совсем такими, на которые надеялись правоохранительные органы.

Фасси и Мюррей перечислили ряд этических проблем и проблем с конфиденциальностью, связанных с нелегальной сетью, и задались вопросом, было ли это вообще законным. И они поставили под сомнение точность системы, которая продается токийским технологическим гигантом NEC. Программное обеспечение отметило 42 человека в течение 6 испытаний, которые проанализировали исследователи; офицеры отклонили 16 матчей как «недостоверные», но поспешили остановить остальные. Они потеряли в толпе 4 человека, но остановили все же 22: только 8 оказались правильными совпадениями.

Полиция увидела проблему по-другому. Они сказали, что количество ложных срабатываний системы было крошечным, учитывая многие тысячи лиц, которые были отсканированы. (Они не ответили на запросы Nature о комментариях для этой статьи.)

Этические вопросы, которые не дают покоя исследованиям в области распознавания лиц

Точность распознавания лиц резко возросла с тех пор, как около десяти лет назад в эту область были внедрены методы «глубокого обучения». Но означает ли это, что он достаточно хорош для использования на низкокачественных изображениях «в дикой природе» — очень спорный вопрос. И остаются вопросы о том, как прозрачно оценивать системы распознавания лиц.

В 2018 году в фундаментальной статье ученых-компьютерщиков Тимнита Гебру, затем из Microsoft Research в Нью-Йорке, а теперь из Google в Маунтин-Вью, Калифорния, и Джой Буоламвини из Массачусетского технологического института в Кембридже было обнаружено, что ведущее программное обеспечение для распознавания лиц пакеты гораздо хуже справились с определением пола женщин и цветных людей, чем с классификацией мужских, белых лиц  С тех пор опасения по поводу демографической предвзятости часто цитировались в призывах к мораторию или запрету программного обеспечения для распознавания лиц.

С тех пор опасения по поводу демографической предвзятости часто цитировались в призывах к мораторию или запрету программного обеспечения для распознавания лиц.

В июне крупнейшее в мире научное вычислительное общество, Ассоциация вычислительной техники в Нью-Йорке, призвала приостановить использование технологии распознавания лиц в частном и государственном секторах из-за «явной предвзятости, основанной на этнической, расовой, гендерной и другие человеческие характеристики», которые, по его словам, нарушают права людей в определенных демографических группах. Компания Axon, производитель нательных камер, которые носят полицейские в США, заявила, что распознавание лиц недостаточно точно для использования в ее продуктах. Некоторые города США запретили использование этой технологии в полиции, а американские законодатели предложили ввести федеральный мораторий.

Компании говорят, что работают над исправлением предубеждений в своих системах распознавания лиц, и некоторые из них заявляют об успехе. Но многие исследователи и активисты настроены глубоко скептически. Они утверждают, что даже если технология превзойдет какой-то эталон по точности, это не развеет более глубоких опасений, что инструменты распознавания лиц используются дискриминационным образом.

Но многие исследователи и активисты настроены глубоко скептически. Они утверждают, что даже если технология превзойдет какой-то эталон по точности, это не развеет более глубоких опасений, что инструменты распознавания лиц используются дискриминационным образом.

Более точные, но все же предвзятые

Системы распознавания лиц часто являются собственностью и окутаны секретами, но специалисты говорят, что большинство из них включают многоэтапный процесс (см. «Как работает распознавание лиц») с использованием глубокого обучения для обучения массивных нейронных сетей на большие наборы данных для распознавания закономерностей. «Все, кто распознает лица, теперь используют глубокое обучение», — говорит Анил Джейн, ученый-компьютерщик из Мичиганского государственного университета в Ист-Лансинге.

Первый этап типичной системы определяет местонахождение одного или нескольких лиц на изображении. Лица в потоке с камеры наблюдения могут быть видны в различных условиях освещения и под разными углами, что делает их более трудными для распознавания, чем, например, на стандартной фотографии в паспорте. Алгоритм будет обучен на миллионах фотографий, чтобы найти «ориентиры» на лице, такие как глаза, нос и рот, и он преобразует информацию в компактный файл размером от менее 100 байт до нескольких килобайт. .

Алгоритм будет обучен на миллионах фотографий, чтобы найти «ориентиры» на лице, такие как глаза, нос и рот, и он преобразует информацию в компактный файл размером от менее 100 байт до нескольких килобайт. .

Сопротивление распространению распознавания лиц

Следующая задача — «нормализовать» лицо, искусственно повернув его во фронтальный, хорошо освещенный вид. Это создает набор лицевых «признаков», которые можно сравнить с извлеченными из существующей базы данных лиц. Обычно это будут фотографии, сделанные в контролируемых условиях, например полицейские фотографии. Поскольку представления функций представляют собой компактные структурированные файлы, компьютер может быстро просмотреть миллионы из них, чтобы найти наиболее близкое соответствие.

Сопоставление лиц с большой базой данных — так называемая идентификация «один ко многим» — является одним из двух основных типов системы распознавания лиц. Другой — индивидуальная проверка, относительно простая задача убедиться, что человек соответствует своей фотографии.

Одним из показателей прогресса является тест поставщика распознавания лиц, независимая сравнительная оценка, которую Национальный институт стандартов и технологий США (NIST) в Гейтерсберге, штат Мэриленд, проводит уже два десятилетия. Десятки лабораторий, как коммерческих, так и академических, добровольно приняли участие в последнем раунде испытаний, который начался в 2018 году и продолжается до сих пор. NIST измеряет производительность пакета программного обеспечения каждой лаборатории на своих собственных наборах данных изображений, которые включают фотографии полицейских в анфас и в профиль, а также изображения, взятые из Интернета. (Американские технологические гиганты Amazon, Apple, Google и Facebook не принимали участия в тестировании.)

В отчетах, опубликованных в конце прошлого года, команда NIST описала огромные шаги вперед в производительности технологии в течение 2018 года, как для поиска «один ко многим» 3 , так и для проверки «один к одному» 4 (см. также go. nature.com/35pku9q). «Мы наблюдаем значительное улучшение точности распознавания лиц», — говорит Крейг Уотсон, инженер-электрик, возглавляющий группу изображений NIST. «Мы знаем, что это во многом благодаря сверточной нейронной сети, — добавляет он, — типу глубокой нейронной сети, которая особенно эффективна при распознавании изображений.

также go. nature.com/35pku9q). «Мы наблюдаем значительное улучшение точности распознавания лиц», — говорит Крейг Уотсон, инженер-электрик, возглавляющий группу изображений NIST. «Мы знаем, что это во многом благодаря сверточной нейронной сети, — добавляет он, — типу глубокой нейронной сети, которая особенно эффективна при распознавании изображений.

Лучшие алгоритмы теперь могут идентифицировать людей по изображению профиля, сделанному в дикой природе, — сопоставляя его с видом спереди из базы данных — примерно так же точно, как лучшее программное обеспечение для распознавания лиц десять лет назад могло распознавать изображения спереди, обнаружил NIST. Распознавание лица в профиль «было долгожданной вехой в исследованиях по распознаванию лиц», пишут исследователи NIST.

Но NIST также подтвердил то, что предполагала работа Буоламвини и Гебру по гендерной классификации: большинство пакетов, как правило, более точны для белых, мужских лиц, чем для цветных людей или для женщин 5 . В частности, лица, классифицированные в базе данных NIST как афроамериканцы или азиаты, были в 10–100 раз чаще ошибочно идентифицированы, чем лица, классифицированные как белые. Ложноположительные результаты также чаще встречались у женщин, чем у мужчин (см. «Ошибочная идентификация»).

В частности, лица, классифицированные в базе данных NIST как афроамериканцы или азиаты, были в 10–100 раз чаще ошибочно идентифицированы, чем лица, классифицированные как белые. Ложноположительные результаты также чаще встречались у женщин, чем у мужчин (см. «Ошибочная идентификация»).

Источник: Реф. 5

Эта неточность, вероятно, отражает дисбаланс в составе учебной базы данных каждой компании, говорит Уотсон — бич, который специалисты по данным часто описывают как «мусор на входе, мусор на выходе». Тем не менее, расхождения между пакетами варьировались, что указывает на то, что некоторые компании, возможно, начали решать проблему, добавляет он.

NEC, которая поставляет программное обеспечение Скотланд-Ярда, отметила, что, согласно анализу NIST, она была «среди небольшой группы поставщиков, где ложные срабатывания, основанные на демографических различиях, были необнаружимы», но что коэффициенты совпадения могли быть скомпрометированы наружным, плохо освещенным или зернистым изображением. картинки.

картинки.

Фальшивые лица

Проверка один на один, например, распознавание законного владельца паспорта или смартфона, стала чрезвычайно точной; здесь искусственный интеллект так же искусен, как и самые зоркие люди. В этой области передовые исследования сосредоточены на обнаружении злонамеренных атак. По словам Джейна, первые системы распознавания лиц для разблокировки телефонов, например, легко обмануть, показав на телефоне фотографию владельца; 3D-распознавание лиц работает лучше. «Сейчас самая большая проблема — очень качественные маски для лица». В рамках одного проекта Джейн и его сотрудники работают над обнаружением таких имитаторов по текстуре кожи.

Но проверка «один ко многим», как обнаружил Мюррей, не так проста. При достаточно большом списке наблюдения количество выявленных ложных срабатываний может легко перевесить количество истинных попаданий.

Баннер протестует против распознавания лиц на футбольном матче в январе этого года в Кардиффе, Великобритания (до пандемии COVID-19). Фото: Athena Pictures/Getty

Фото: Athena Pictures/Getty

Это проблема, когда полиции нужно быстро принять решение об остановке кого-либо. Но ошибки случаются и в более медленных исследованиях. В январе Роберт Уильямс был арестован в своем доме в Фармингтон-Хиллз, штат Мичиган, после того, как полицейская система распознавания лиц ошибочно идентифицировала его как вора часов на основании размытых кадров с камер наблюдения за чернокожим, которые соответствовали его водительским правам. Американский союз гражданских свобод (ACLU), некоммерческая организация в Нью-Йорке, подала жалобу на инцидент в полицию Детройта в июне и выпустила видео, в котором Уильямс рассказывает о том, что произошло, когда детектив показал ему фотографии с камер наблюдения. бумага. «Я взял эту бумагу, поднес ее к лицу и сказал: «Это не я». Надеюсь, вы не думаете, что все чернокожие похожи друг на друга». А потом он сказал: «Компьютер говорит, что это вы», — сказал Уильямс. Он был освобожден после задержания на 30 часов. Поверенный ACLU Фил Мэйор говорит, что технология должна быть запрещена. «Это не работает, а даже когда работает, это остается слишком опасным инструментом для правительств, чтобы использовать его для наблюдения за своими гражданами без какой-либо убедительной отдачи», — говорит он.

«Это не работает, а даже когда работает, это остается слишком опасным инструментом для правительств, чтобы использовать его для наблюдения за своими гражданами без какой-либо убедительной отдачи», — говорит он.

Вскоре после жалобы ACLU начальник полиции Детройта Джеймс Крейг признал, что программное обеспечение, если оно используется само по себе, неправильно идентифицирует дела «в 96% случаев». Ссылаясь на опасения по поводу расовой предвзятости и дискриминации, по меньшей мере 11 городов США запретили распознавание лиц государственными органами за последние 18 месяцев. Но полиция Детройта до сих пор использует эту технологию. В конце 2019 года силы приняли политику запрета наблюдения с камер в реальном времени и использования программного обеспечения только для неподвижных изображений и в рамках уголовных расследований; Как заявил Крейг в июне, Уильямс был арестован до того, как эта политика вступила в силу. (Он не ответил на Природа запросы на комментарии.)

Приостановить использование технологии распознавания лиц до тех пор, пока она не будет регулироваться

Другие аспекты анализа лица, такие как попытка определить чью-то личность на основе их выражений лица, еще более противоречивы. Исследователи показали, что это не работает 6 — даже самое лучшее программное обеспечение можно обучить только на изображениях, помеченных догадками других людей. Но компании по всему миру все еще покупают непроверенную технологию, которая оценивает личности кандидатов на собеседовании на основе видеозаписей их разговоров.

Исследователи показали, что это не работает 6 — даже самое лучшее программное обеспечение можно обучить только на изображениях, помеченных догадками других людей. Но компании по всему миру все еще покупают непроверенную технологию, которая оценивает личности кандидатов на собеседовании на основе видеозаписей их разговоров.

Нурия Оливер, ученый-компьютерщик из Аликанте, Испания, говорит, что правительства должны регулировать использование распознавания лиц и других потенциально полезных технологий для предотвращения злоупотреблений. «Системы выводятся на свободу без надлежащей оценки их производительности или процесса проверки и воспроизводимости», — говорит Оливер, который является соучредителем и вице-президентом региональной сети под названием Европейская лаборатория обучения и интеллектуальных систем. .

Постоянные проблемы

В некоторых предложениях по регулированию содержится призыв к властям установить стандарты точности и требовать, чтобы люди проверяли выводы любого алгоритма. Но стандарт, основанный, скажем, на прохождении тестов NIST, сам по себе является слишком низкой планкой, чтобы оправдать развертывание технологии, говорит Дебора Раджи, научный сотрудник интернет-фонда Mozilla из Оттавы, специализирующаяся на аудите систем распознавания лиц.

Но стандарт, основанный, скажем, на прохождении тестов NIST, сам по себе является слишком низкой планкой, чтобы оправдать развертывание технологии, говорит Дебора Раджи, научный сотрудник интернет-фонда Mozilla из Оттавы, специализирующаяся на аудите систем распознавания лиц.

Дебора Раджи специализируется на аудите систем распознавания лиц. Фото: Деб Раджи

В этом году Раджи, Буоламвини, Гебру и другие опубликовали еще одну статью о производительности коммерческих систем и отметили, что, хотя некоторые фирмы улучшили классификацию пола по лицам светлокожих и темнокожих, они все еще хуже угадывали возраст человека. с лиц с более темной кожей 7 . «Процесс оценки невероятно незрелый. Каждый раз, когда мы понимаем новое измерение для оценки, мы обнаруживаем, что отрасль работает не на том уровне, на котором, по ее мнению, она была», — говорит Раджи. По ее словам, важно, чтобы компании раскрывали больше информации о том, как они тестируют и обучают свои системы распознавания лиц, и консультировались с сообществами, в которых будет использоваться эта технология.

Технические стандарты не могут предотвратить дискриминационное использование систем распознавания лиц, говорит Амба Как, юрист из Института AI Now при Нью-Йоркском университете. «Будут ли эти системы еще одним инструментом для пропаганды повсеместных дискриминационных практик в полиции?» Как добавляет Как, операторы-люди часто в конечном итоге подтверждают предвзятость системы, а не исправляют ее. Такие исследования, как внешний обзор Скотленд-Ярда, показывают, что люди склонны переоценивать достоверность технологии, даже когда они видят ложное совпадение компьютера рядом с реальным лицом. «Просто добавить пункт «убедитесь, что в цикле есть человек» недостаточно», — говорит она.

Как и другие поддерживают мораторий на любое использование распознавания лиц не только потому, что технология еще недостаточно хороша, но и потому, что необходимо более широкое обсуждение того, как предотвратить ее неправильное использование. По словам Мюррея, технология будет улучшаться, но останутся сомнения в законности использования постоянной сети для невинных людей и в отношении критериев, по которым люди включаются в список наблюдения.

Опасения по поводу конфиденциальности, этики и прав человека будут расти. Крупнейшая в мире биометрическая программа в Индии включает использование распознавания лиц для создания гигантской национальной системы удостоверений личности под названием Aadhaar. Любой, кто живет в Индии, может пойти в центр Aadhaar и сфотографироваться. Система сравнивает фотографию с существующими записями о 1,3 миллиарда человек, чтобы убедиться, что заявитель еще не зарегистрировался под другим именем. «Это ошеломляющая система, — говорит Джейн, работавший в ней консультантом. «Прелесть этого в том, что он гарантирует, что у одного человека будет только одно удостоверение личности». Но критики говорят, что это превращает владельцев карточек в граждан второго сорта, а некоторые утверждают, что это использовалось для удаления законных граждан из списков избирателей перед выборами.

Почему ИИ с глубоким обучением так легко обмануть

И самое печально известное использование биометрических технологий — это государственная слежка, созданная китайским правительством в провинции Синьцзян, где алгоритмы распознавания лиц используются для выявления и преследования представителей религиозных меньшинств.